#5 ¿Como es Barbie para la Inteligencia Artificial? - Sesgos y prejuicios

Impulsando Negocios, Potenciando Personas

¿Qué pasaría si le pidiéramos a una aplicación de inteligencia artificial que creara una imagen de cómo sería una muñeca Barbie en cada país del mundo? La respuesta la tuvimos el pasado mes de julio de 2023 cuando BuzzFeed usó Midjourney (una aplicación de IA para crear imágenes a partir de textos) para crear 195 Barbies.

¿Resultado? Imágenes basadas en estereotipos y sesgos.

La Barbie de sudan del sur lleva armas…

la del Líbano está sobre un montón de escombros…

La de Bahamas nos cuenta lo ricos que son…

o el caso de Alemania donde va vestida con ropa militar.

La primera gran conclusión es que los programas de inteligencia artificial no son perfectos, entre otras muchas ocasos porque los humanos que los crean, desarrollan y entrenan, tampoco lo son.

Podemos atribuir esta imperfección a los sesgos, es decir, a como las desigualdades o los prejuicios que tenemos los humanos se filtran en los algoritmos de Inteligencia artificial produciendo, a su vez, resultados finales que según el punto de vista con que los miramos consideramos incorrectos.

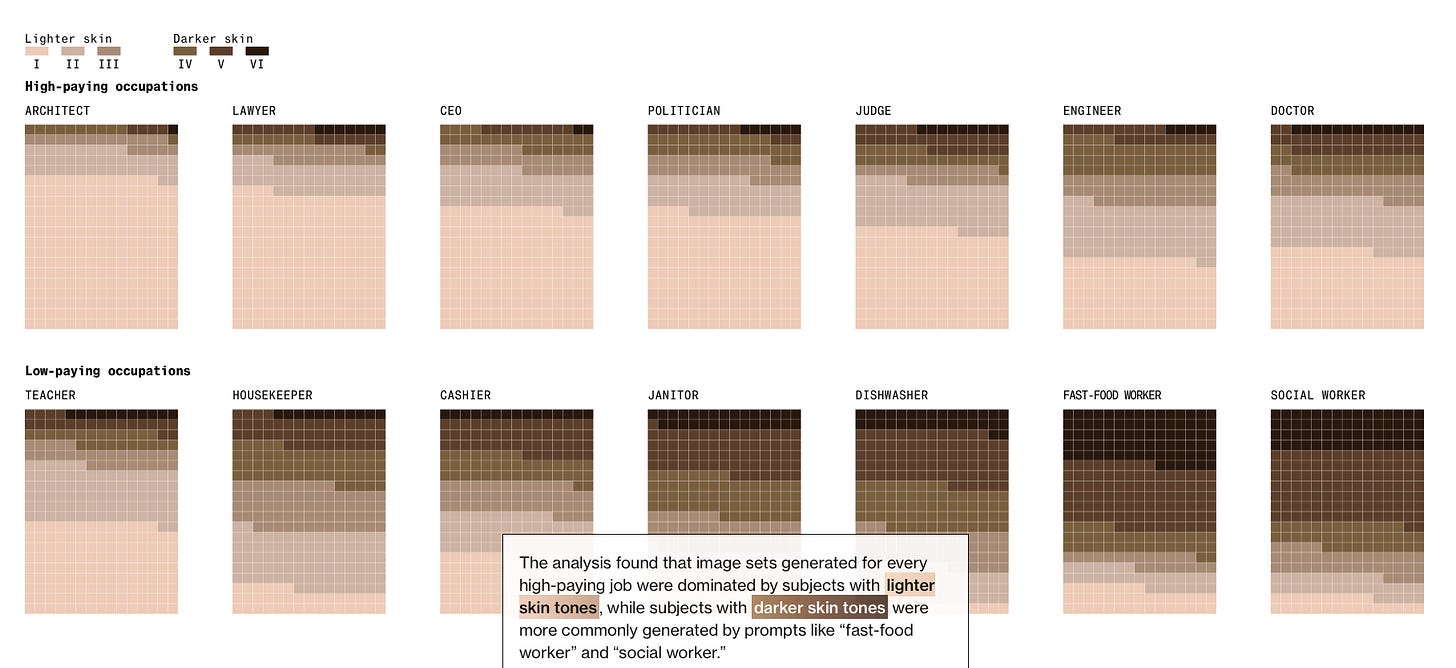

En un análisis de más de 5.000 imágenes de IA, Bloomberg descubrió que las imágenes asociadas a puestos de trabajo mejor pagados mostraban a personas con tonos de piel más claros, y que en los resultados de la mayoría de los puestos profesionales predominaban los hombres.

A modo de contraste, para la IA los arquitectos son mayoritariamente hombres blancos caucásicos, mientras que los trabajadores sociales son mayoritariamente mujeres afroamericanas (En la imagen se puede apreciar, por profesión, el color de piel de cada una de estas 5.000 imágenes).

Pero ¿Cuál es el origen de estos sesgos?

De entre la multitud de posibles orígenes, podemos destacar aquellos que la ciencia y la investigación ha definido como los más relevantes:

Basados en Datos

Si los datos utilizados para entrenar un algoritmo contienen desigualdades o reflejan prejuicios existentes en la sociedad (por ejemplo, sesgos de género, raza, edad o ubicación geográfica), la IA puede aprender y perpetuar esas discriminaciones.

Fruto de los algoritmos

Ocurren durante el diseño y la implementación de los algoritmos. Pueden surgir debido a la elección de características o variables que pueden influir en la toma de decisiones y crear parcialidades no intencionadas en los resultados.

Contextuales

Resultan de la falta de comprensión del contexto en el que se utilizará la IA. Un algoritmo puede funcionar bien en un entorno específico, pero no en otros, lo que lleva a resultados parciales o erróneos (sería el ejemplo de las barbies que da inicio a este articulo; con total seguridad si la prueba se hiciera en un contexto distinto -otro país, por ejemplo- algunos de los resultados cambiarían).

De interpretación

Surgen cuando los humanos interpretan los resultados de los modelos de IA de manera sesgada, favoreciendo información que confirma sus creencias preexistentes o malinterpretando la salida de la IA. En los casos en los que aceptamos como “correctos” los resultados que nos ofrecen estos algoritmos generativos, por ejemplo.

Basados en la Omisión

Pueden ocurrir cuando los datos utilizados para entrenar la IA no incluyen ciertos grupos o situaciones, lo que resulta en la omisión de información relevante y, por lo tanto, en decisiones parciales o inexactas

Estos sesgos pueden tener consecuencias muy importantes en función de la aplicación que se haga de los resultados de la IA. Desde perpetuar prejuicios, como pensar, como hemos visto con el análisis de Bloomberg, que las profesiones mejor pagadas están ocupadas por hombres blancos, hasta provocar errores de diagnósticos médicos porque la IA se ha entrenado con un subconjunto de datos (una raza concreta, un intervalo de edad específico o una fase concreta de una enfermedad).

¿Cómo podemos solucionarlo?

Desde el punto de vista teórico existen varias formas para poder hacerlo:

Análisis Exploratorio de Datos: realizar un análisis exhaustivo de los conjuntos de datos utilizados para entrenar los modelos de IA. Identificar desequilibrios o sesgos en las distribuciones de datos.

Pruebas de equidad: aplicar pruebas específicas para verificar la equidad en la toma de decisiones de la IA para diferentes grupos demográficos. Evaluar si los resultados son consistentes independientemente de las características personales.

Auditorías de algoritmos: realizar auditorías periódicas en los sistemas de IA para identificar patrones de sesgo. Evaluar las decisiones tomadas por el algoritmo y analizar si reflejan parcialidades no deseadas.

Simulaciones y escenarios contrarios: simular situaciones alternativas o contrarias para evaluar cómo reaccionaría la IA en contextos donde las decisiones esperadas podrían ser diferentes. Esto ayuda a identificar posibles sesgos ocultos.

Análisis de sensibilidad: evaluar la sensibilidad del modelo a diferentes conjuntos de datos. Identificar cómo los cambios en los datos afectan las decisiones del modelo.

Pero la realidad siempre supera la teoría. Más allá de temas específicos que puedan dificultar estas resoluciones, como distintas regulaciones para la IA, que los datos no son estáticos y se van creando datos nuevos, que la transparencia en cómo funcionan los algoritmos no siempre es la deseada, o que las motivaciones éticas o morales pueden traer subjetividad en este análisis, un elemento sobrevuela por encima de todos ellos…

Una vez un modelo de IA está funcionado acabará influyendo en las personas que lo utilicen, estas personas podemos estar incorporando estos sesgos de forma inconsciente en nuestra propia toma de decisiones.

¿será que al final vamos a creer y dar por buenos los resultados de un algoritmo de IA hasta el punto de interiorizar estos sesgos? La respuesta en el próximo artículo.

Y, como siempre, Seguimos!